El avance de la IA en los últimos años y su importante impacto social ha conducido a generar un debate sobre el doble uso de estas tecnologías y sus campos potenciales de aplicación, poniendo el foco en las amenazas para la seguridad que éstas representan y su evolución futura.

Entre las enormes posibilidades de aplicación que tienen los modelos algorítmicos de IA, debemos ubicar nuestro interés en las denominadas deepfakes o falsificaciones profundas, por el elevado riesgo que representan para nuestras sociedades, debido a sus implicaciones para la convivencia, la confianza institucional y la estabilidad democrática. El término procede del acrónimo anglosajón resultante de la combinación de los términos deep como abreviatura de deep learning y fake (falso) y designa aquellos contenidos (imagen, audio, vídeo o texto) creados o manipulados mediante IA incluyendo modelos de aprendizaje automático (machine learning) o aprendizaje profundo (deep learning). La difusión de deepfakes se ha incrementado de forma exponencial en los últimos años. Entre la confluencia de factores que permiten explicar este auge destaca la democratización en el acceso de estas tecnologías[1], por no requerir de conocimiento técnico previo por parte del usuario, con el añadido además de que en muchos casos resultan gratuitas o bien presentan un precio muy reducido, circunstancia ésta que ha llevado a que reciban el nombre de cheapfakes[2]. Asimismo, hay que destacar cómo factor intensificador de la amenaza que estas aplicaciones representan la rápida evolución de los modelos algorítmicos en las que se basan en un intento constante por alcanzar un mayor realismo, lo cual supone un problema a la hora de desarrollar arquitecturas de detección eficaces, ya que en buena parte sus modelos se orientan a la identificación de atributos que muestran inconsistencia con la realidad (parpadeo y movimiento ocular, flujo sanguíneo, inflexiones de voz, etc…).

Se han establecido modos, herramientas y recursos propios y ajenos para contar los hallazgos y descubrimientos producto de los resultados de las investigaciones, o simplemente contar aspectos referentes a la ciencia. Ahora, qué elementos de la narrativa audiovisual como componentes del lenguaje, recursos de edición y sobre todo principios estructurales pueden ayudar a transmitir mejor nuestros mensajes.

En esta entrada comentaremos algunos recursos tanto narrativos como de herramientas específicas de la edición que permiten organizar de manera más atractiva nuestros mensajes. Recursos como las figuras estructurales y herramientas como los modos de edición o las formas de articulación entre planos.

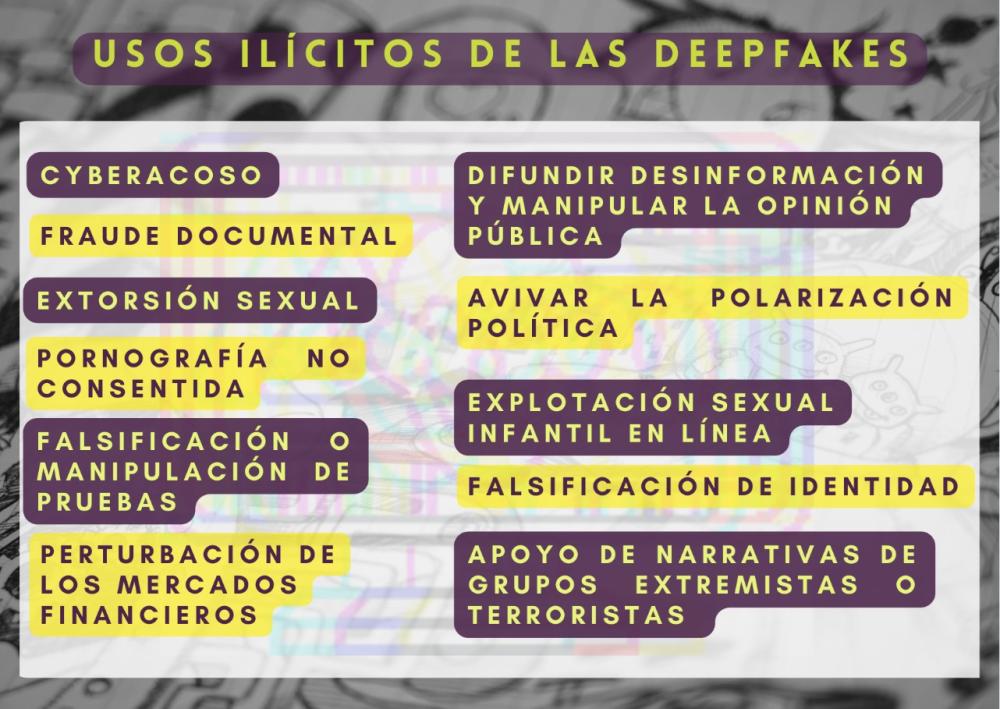

USOS ILÍCITOS DE LAS DEEPFAKES

El uso de tecnología deepfake por parte de actores hostiles se ha convertido en una práctica regular como parte de sus actividades ilícitas (Marwan & Almalki, 2019).Ya la primera mención al término en 2017 estuvo ligada a la pornografía no consensuada (Westerlund, 2019; (Collins & Ebrahim, 2021), empleándose para simular la representación de reconocidas celebridades. Posteriormente, el repertorio fue ampliado a personas anónimas. Hoy el abanico de usos ilícitos resulta infinito. Así se ha constatado el uso de deepfake de audio en casos de estafa, para simular la voz de presidentes y ejecutivos de empresas[3][4]. También se ha observado su utilización como prueba fraudulenta en procesos penales o para desprestigiar u ocasionar daños reputacionales. Desde hace tiempo, también están presentes en campañas de influencia informativa (ligadas a prácticas de microtargeting, acompañando el contenido desinformativo o bien de manera aislada)[5], siendo observadas en procesos electorales o en contextos de crisis. Menciónese como ejemplo la difusión de videos del presidente Zelensky declarando la rendición de las tropas ucranianas[6].

De acuerdo con un informe de 2021 elaborado conjuntamente por EUROPOL, TrendMicro y UNICRI16 titulado ‘Malicious Uses and Abuses of Artificial Intelligence’[7] se ha identificado su aplicación ilícita en los siguientes ámbitos:

ENFOQUES REGULATORIOS EXISTENTES

Existe una amplia controversia en torno a la promulgación de legislaciones nacionales específicas para regular las deepfakes debido a la dificultad que entraña su conciliación con derechos y libertades fundamentales, pero también por la problemática a la hora de atribuir responsabilidades ligadas a la autoría y difusión de los contenidos. Asimismo, es importante mencionar la existencia en algunos países de vacíos legales significativos, pudiendo destacar la ausencia de responsabilidad civil extracontractual, como por ejemplo en el caso de la vulneración de los derechos de imagen de las personas fallecidas.

Esta situación ha llevado a que en la actualidad, la adopción de mecanismos legales para regular las deepfakes sea una excepción apenas relegada a un conjunto reducido de casos. Los estados de Virginia (2019) y California (2019) en EE.UU[8] y Gales e Inglaterra (2022)[9] cuentan con legislaciones contra las deepfakes que simulan pornografía; en Texas (2019) su difusión en comicios electorales está prohibida. El gobierno chino (2020), por su parte, ha abogado por la restricción completa de estos contenidos[10].

En el caso de la UE la adopción de mecanismos reguladores quedará englobado dentro de la proposición de ley sobre IA (2021), con referencias concretas contenidas en los art. 52 y 71. Según el planteamiento general de la normativa que establece un sistema de etiquetado para las tecnologías de IA avisando sobre su nivel de riesgo (mínimo, limitado, alto e inaceptable), los proveedores de software deepfake estarían obligados a cumplir con esta obligación. Asimismo, el art. 52 impone a los usuarios el requerimiento de etiquetar los contenidos como artificiales o manipulados. La propuesta no recoge, sin embargo, mecanismos punibles.

Adicionalmente, este marco es ya complementado por diferentes mecanismos en vigor como las leyes de copyright, de derechos de imagen, la ley General de Protección de Datos, la Digital Service Act, la Digital Market Act y la EU Audiovisual Media Service Directive.

En la actualidad, existe un debate sobre la suficiencia de estos mecanismos. La ausencia de sanciones en la propuesta europea de regulación de la IA, unido a los vacíos o exenciones recogidas en el resto de legislaciones citadas -supeditación de derechos absolutos a fundamentales, exenciones relativas al uso de los contenidos,…- , junto con la dificultad añadida de la atribución de autorías hace que en la práctica los actores maliciosos puedan seguir obteniendo ventaja del uso de esta tecnología. Es por ello que se requiere de enfoques preventivos complementarios, resultando esencial una mayor implicación por parte de las plataformas de distribución de contenidos unido a un mayor esfuerzo y despliegue de recursos destinados a la alfabetización visual.

Referencias

Albahar, Marwan & Almalki, Jameel (2019). Deepfakes: threats and countermeasures systematic review, Journal of Theoretical and Applied Information Technology, 97:22, pp. 3242-3250. http://www.jatit.org/volumes/Vol97No22/7Vol97No22.pdf

Collins, Aengus; Touradj Ebrahimi (2021). Risk governance and the rise of deepfakes, International Risk Governance Centre https://infoscience.epfl.ch/record/285637

European Parliament (2020). Tackling deepfakes in European policy, European Parliament Research Service, https://www.europarl.europa.eu/RegData/etudes/STUD/2021/690039/EPRS_STU(2021)690039_EN.pdf

Leong, Dymples (2023). Deepfakes and Disinformation Pose a Growing Threat in Asia, The Diplomat, 23 de marzo 2023. https://thediplomat.com/2023/03/deepfakes-and-disinformation-pose-a-growing-threat-in-asia/

UK Government (2022). New laws to better protect victims from abuse of intimate images https://www.gov.uk/government/news/new-laws-to-better-protect-victims-from-abuse-of-intimate-images

US Congressional Research Service, Deep fakes and National Security, In focus, 3 june, 2022. https://crsreports.congress.gov/product/pdf/IF/IF11333/1

US Homeland Security Department (2021). Increasing Threat of Deepfake Identities. https://www.dhs.gov/sites/default/files/publications/increasing_threats_of_deepfake_identities_0.pdf Westerlund, Mika (2019). The Emergence of Deepfake Technology: A Review, Technology Innovation Management Review, 9:11, pp. 39-52 https://timreview.ca/sites/default/files/article_PDF/TIMReview_November2019%20-%20D%20-%20Final.pdf

[1] Congressional Research Service, Deep fakes and National Security, In focus, 3 june, 2022. https://crsreports.congress.gov/product/pdf/IF/IF11333/1

[2] https://www.dhs.gov/sites/default/files/publications/increasing_threats_of_deepfake_identities_0.pdf

[3] https://www.forbes.com/sites/thomasbrewster/2021/10/14/huge-bank-fraud-uses-deep-fake-voice-tech-to-steal-millions/?sh=2e21ace17559

[4] https://www.wsj.com/articles/fraudsters-use-ai-to-mimic-ceos-voice-in-unusual-cybercrime-case-11567157402

[5]https://www.europarl.europa.eu/RegData/etudes/STUD/2021/690039/EPRS_STU(2021)690039_EN.pdf

[6] https://www.youtube.com/watch?v=X17yrEV5sl4

[7] https://www.europol.europa.eu/publications-events/publications/malicious-uses-and-abuses-of-artificial-intelligence

[8] https://www.dhs.gov/sites/default/files/publications/increasing_threats_of_deepfake_identities_0.pdf [1]

[9] https://www.gov.uk/government/news/new-laws-to-better-protect-victims-from-abuse-of-intimate-images

[10] https://thediplomat.com/2023/03/deepfakes-and-disinformation-pose-a-growing-threat-in-asia/